Mehr als zwei Jahre nach dem Start von OpenAIs ChatGPT, der eine Welle an Interesse für generative Künstliche Intelligenz (KI) auslöste, bleiben die langfristigen Implikationen dieser Technologie hochgradig ungewiss. Die Innovationsgeschwindigkeit ist rasant, regulatorische Rahmenbedingungen entwickeln sich noch und der endgültige wirtschaftliche Nutzen vieler KI-Anwendungen muss sich erst noch erweisen. Doch inmitten dieser Unsicherheiten beginnen sich die Strategien der Technologiegiganten abzuzeichnen: Während einige – wie Alphabet und Meta – stark in die Entwicklung eigener Modelle investieren, verfolgen andere – wie Microsoft und Amazon – einen eher modellagnostischen Ansatz.

In einem Umfeld, in dem Fortschritte bei grossen Sprachmodellen (Large Language Models, LLMs) schnell eingeholt werden können, dürfte die Fähigkeit zur Skalierung von Distribution über etablierte Unternehmens- und Verbraucherplattformen entscheidender sein als rein technische Differenzierung. In diesem Newsletter untersuchen wir, wie zwei Unternehmen aus dem Seilern-Universum – Microsoft und Alphabet – diese Herausforderung angehen. Ihre Strategien unterscheiden sich zwar in der Ausführung, doch beide haben die Notwendigkeit grosser Vorabinvestitionen erkannt, um neue Umsatzquellen zu erschliessen und ihre Wettbewerbsposition zu stärken, , verankert in ihrer Rolle als Cloud-Hyperscaler und der damit verbundenen starken Vertriebskraft.

Microsofts modellagnostischer Ansatz

Die generative KI-Strategie von Microsoft konzentriert sich auf den Vertrieb über einen LLM-agnostischen Ansatz. Im Gegensatz zu Wettbewerbern, die vorrangig auf die Entwicklung von Frontier-Modellen setzen, konzentriert sich Microsoft strategisch auf den nachgelagerten Einsatzbereich – in der Überzeugung, dass sich grosse Sprachmodelle (LLMs) zunehmend zu einer Commodity entwickeln.

Zwar stammt ein grosser Teil der KI-bezogenen Umsätze von Microsoft, die auf 13 Mrd. US-Dollar pro Jahr geschätzt werden, aus dem Training der Modelle von OpenAI, das über die Azure-Plattform abgewickelt wird (die sogenannte „Compute Layer“ in der untenstehenden Abbildung). Doch das Unternehmen verlagert seine Infrastrukturinvestitionen und seine Umsatzgenerierung zunehmend in Richtung KI-Inferenz-Workloads (die „Application Layer“), die unmittelbare Monetarisierungsmöglichkeiten versprechen und aus Sicht von Microsoft langfristig über das grössere Potenzial verfügen.

Abbildung 1: Beispiel für die Lieferkette des Large Language Model (LLM)1

Quelle: The Ada Lovelace Institute

Ein Beispiel dafür ist die Azure AI Foundry, die Unternehmenskunden Zugang zu über 10.000 Modellen bietet – darunter exklusive OpenAI-Modelle und vielen anderen Open-Source-Modellen von Anbietern wie Meta und DeepSeek sowie neuerdings auch Angebote von xAI. Ziel der Foundry ist es, Entwicklern eine einheitliche Plattform bereitzustellen, auf der sie jeweils das für ihren Einsatzzweck am besten geeignete Modell verwenden und KI-Modelle direkt nutzen, testen und implementieren können. Langfristig soll damit die Nachfrage nach Inferenz-Computing auf dem Azure-Netzwerk gesteigert werden, indem der Zugang zu einem breiten Spektrum an KI-Modellen so einfach und attraktiv wie möglich gestaltet wird.

Dieser modellagnostische Ansatz stellt sicher, dass Microsoft eine zentrale Rolle im KI-Ökosystem einnimmt – unabhängig davon, welche spezifischen KI-Modelle sich langfristig durchsetzen.

Die sich entwickelnde Partnerschaft mit OpenAI, die 2019 begann, gibt dabei wichtige Hinweise auf Microsofts strategische Ausrichtung. Insbesondere ist Microsoft dem ehrgeizigen „Stargate-Projekt“ von OpenAI ferngeblieben, das in den nächsten vier Jahren 500 Mrd. USD in die Recheninfrastruktur investieren will. Microsoft behält zwar die exklusiven Vertriebsrechte für die Modelle von OpenAI, doch seine Entscheidung, die Infrastrukturverpflichtungen für Schulungszwecke nicht wesentlich zu erhöhen, steht im Einklang mit der breiteren modellagnostischen Strategie des Unternehmens. Das Ziel ist es, Azure als Plattform der Wahlzu etablieren – unabhängig davon, ob es sich dabei um OpenAI-Modelle handelt oder um Modelle, die von Kunden für ihre Inferenzanwendungen gewählt werden.

Anstatt Kapitalausgaben in Erwartung zukünftiger Durchbrüche aggressiv auszuweiten, kalibriert Microsoft seine inkrementellen Investitionen auf der Angebotsseite – etwa in GPU-Cluster, Erweiterung von Rechenzentren oder die Entwicklung eigener Modelle – eng an der beobachtbaren Kundennachfrage und dem realisierten Wert aus den Inferenz-Workloads. In der Praxis bedeutet das, dass Microsoft Nutzungsmuster, Übernahmequote in Unternehmenund Umsatzbeiträge aus eingesetzten KI-Werkzeugen genau analysiert und nutzt diese Messgrößen, um daraus Rückschlüsse auf weitere Infrastrukturinvestitionen zu ziehen. Dieses nachfragegetriebene Vorgehen sorgt dafür, dass Investitionen dort erfolgen, wo eine höhere Nutzerbindung und klarere sowie verlässlichere Ertragsperspektiven erwartet werden können.

Alphabets technischer und kostenbezogener Vorsprung

Alphabets Ansatz für generative KI basiert auf seiner Philosophie der kontinuierlichen Innovation, die seine Fähigkeiten in der Forschung über Google DeepMind, in der Infrastruktur mit seinem Google Cloud Service und im Vertrieb mit seinen Produkten und Dienstleistungen, die von Milliarden von Kunden weltweit genutzt werden, nutzt. Obwohl das Unternehmen auch Drittanbieter-Modelle zugänglich macht, investiert es gezielt in den Aufbau seines eigenen generativen KI-Ökosystems mit seiner multimodalen LLM-Familie, Gemini.2 Obwohl alle drei großen Hyperscaler (Amazon, Microsoft und Google) umfassende Cloud-Dienste anbieten, wird Google oft als Anbieter mit der am stärksten vertikal integrierten Cloud-Infrastruktur genannt. Diese reicht von Unterseekabeln bis hin zur umfassenden Nutzung hauseigener, speziell entwickelter Chips und bringt mehrere strategische Vorteile mit sich.

Ein herausragendes Beispiel dafür sind die intern entwickelten Tensor Processing Units (TPUs), Chips, die speziell für KI-Berechnungsprozesse entwickelt wurden. Seit ihrem ersten Einsatz in den Rechenzentren des Unternehmens im Jahr 2015 treiben sie heute das gesamte Training und die Inferenz der hochmodernen Gemini-Modelle an. Dank jahrelanger kontinuierlicher Iteration haben die TPUs Google in die Lage versetzt, einige der besten KI-Modelle seiner Klasse anzubieten, und das auch noch mit bemerkenswerter Kosteneffizienz.

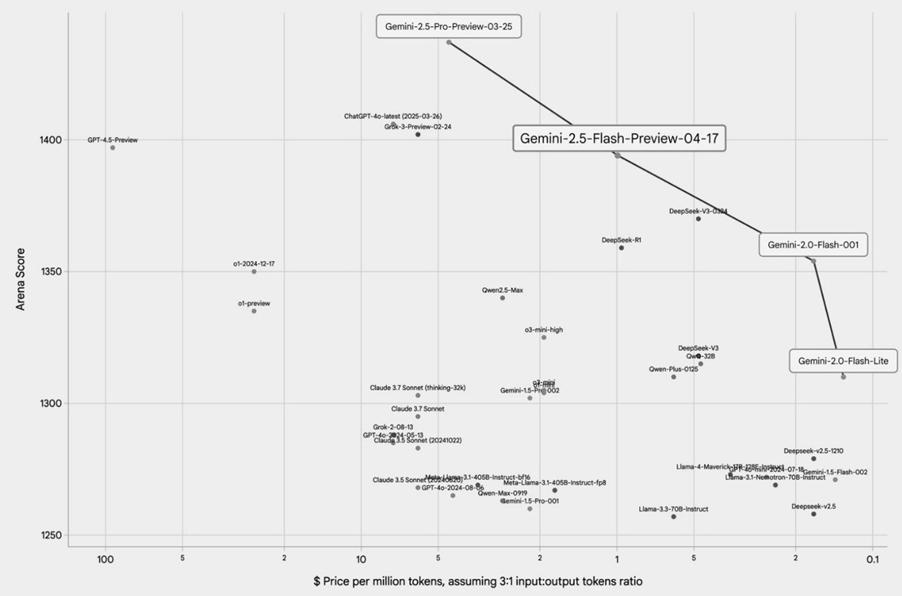

Wie die nachstehende Abbildung zeigt, operieren Googles Modelle an der „Pareto-Grenze“ von Leistung (auf der Y-Achse) und Kosten pro Recheneinheit (auf der X-Achse), was sie für die Kunden sehr attraktiv macht. Mit anderen Worten: Jede Alternative wäre für den Nutzer suboptimal, so dass jeder Gewinn in einem Bereich (z. B. Preis) zwangsläufig einen Kompromiss in einem anderen Bereich (z. B. Leistung) erfordern würde.

Abbildung 2: Leistung des Large Language Model (LLMs) im Vergleich zu den Kosten pro Rechenleistung

Quelle: Google for Developers Blog (17. April 2025)

Diese Chips verschaffen Google einen strukturellen Kostenvorteil, der sich durch den gesamten KI-Bereich des Unternehmens zieht. Während Wettbewerber wie OpenAI (abhängig von Microsoft Azure) und Anthropic (abhängig von Amazon Web Services) für ihre Rechenanforderungen teure externe Cloud-Infrastruktur beschaffen müssen – oft unter Einbeziehung dessen, was manche als „Nvidia-Steuer“ auf High-End-GPUs bezeichnen – kann Google durch seine proprietäre Hardware einen erheblichen Teil dieser externen Kosten umgehen.

Die Veröffentlichung der äußerst wettbewerbsfähigen Open-Source-KI-Modelle von DeepSeek im Februar offenbarte die schwindelerregenden Kostenineffizienzen vieler Entwickler großer Sprachmodelle (LLMs) und war ein deutliches Warnsignal für die Branche. Doch für Google mit seinen jahrelangen Investitionen in kostenoptimiertes Training und einem Jahrzehnt kontinuierlicher Iteration und Verbesserung seiner TPUs blieb die Auswirkung bemerkenswert gedämpft. In einem aktuellen Interview betonte Alphabet-CEO Sundar Pichai, dass Google bei einem internen Vergleich mit den DeepSeek-Modellen feststellte, dass die eigenen Gemini-Modelle ebenso effizient und in manchen Fällen sogar überlegen seien.

Dies unterstreicht den bedeutenden Vorsprung, den Google durch seinen integrierten Hardware-Ansatz erzielt.

Distribution bleibt entscheidend

Auch wenn der derzeitige Hype rund um generative KI unaufhaltsam erscheint, besteht immer das Risiko, dass die Nachfrage schneller abkühlt als erwartet. So unwahrscheinlich dieses Szenario heute auch wirken mag – Alphabet und Microsoft sind dank ihres Status als Cloud-Hyperscaler und ihrer einzigartigen Distributionsstärke besonders gut gegen einen solchen Abschwung abgesichert. Selbst wenn das unmittelbare Interesse an bestimmten KI-Anwendungen nachlassen sollte, wird die grundlegende Nachfrage nach Cloud-Computing, Datenspeicherung und unternehmenskritischer Software bestehen bleiben.

Während sich das Feld der generativen KI weiterentwickelt, werden die langfristigen Gewinner nicht allein durch die technische Überlegenheit ihrer Modelle bestimmt, sondern vor allem durch ihre Fähigkeit, diese Modelle effektiv und im grossen Stil zu vertreiben.

Man betrachte das Beispiel OpenAI: Obwohl das Unternehmen weithin als führend in der Modellinnovation im Bereich Künstliche Intelligenz gilt, ist seine operative und kommerzielle Tragfähigkeit untrennbar mit Microsoft verbunden. Im Rahmen ihrer Partnerschaft nutzt OpenAI Microsoft Azure für sämtliche Rechenanforderungen,3 wobei alle API-Workloads ausschliesslich über Azure gehostet werden.

Diese Konstellation verschafft Microsoft nicht nur exklusiven Zugang zu OpenAIs Spitzentechnologie, sondern stärkt auch die Rolle von Azure als fundamentale Ebene im aufkommenden KI-Ökosystem. Entscheidend ist jedoch, dass dies gleichzeitig eine erhebliche strategische Einschränkung für OpenAI bedeutet: Die Abhängigkeit von Microsofts Infrastruktur und Distributionskanälen begrenzt die Unabhängigkeit des Unternehmens und erhöht sein operatives Risiko. Ohne eigene Cloud-Infrastruktur auf Hyperscaler-Niveau ist OpenAI zunehmend auf Microsoft angewiesen – nicht nur für die notwendige Rechenleistung für Training und Inferenz, sondern auch für den Zugang zu Kunden an zentralen unternehmerischen Schnittstellen. Diese tiefgreifende Abhängigkeit macht den Weg zu einer nachhaltig profitablen Geschäftsentwicklung für OpenAI deutlich unsicherer.

m Gegensatz dazu liegt die Stärke von Hyperscalern wie Alphabet und Microsoft in ihrer einzigartigen Kontrolle über die fundamentale Ressource für KI – die Recheninfrastruktur – sowie in ihrer Fähigkeit, diese mit extremer Effizienz im grossen Massstab zu betreiben, unterstützt durch ihre weitreichenden Distributionsmöglichkeiten.

Wie meine Kollegin Nina bereits aufgezeigt hat, lässt sich Googles Strategie im Kern durch das langjährige Motto zusammenfassen: „Focus on the user and all else will follow“.4 Indem Google fortschrittliche KI-Funktionen nahtlos in bestehende Produkte und Dienste integriert – etwa Android, Gmail, YouTube, Workspace oder die Suche – die bereits von Milliarden Menschen genutzt werden, gelingt es dem Unternehmen, die Nutzerbindung zu erhöhen und personalisierte Erlebnisse zu schaffen.

Diese hohe Nutzungshäufigkeit, verbunden mit enger Produktintegration und kontinuierlicher Datensammlung, bildet eine starke Grundlage für Nutzerbindung und letztlich auch für Monetarisierung.

Ähnlich verfährt Microsoft, indem das Unternehmen seinen KI-gestützten digitalen Assistenten Copilot5 gezielt in weit verbreitete Softwarelösungen integriert. Damit werden KI-Funktionen genau dort bereitgestellt, wo ein Grossteil der Unternehmensarbeit ohnehin bereits stattfindet – ohne dass es neuer, speziell entwickelter Anwendungen bedarf, um KI zur Wirkung zu bringen. Durch die Einbindung von KI-Funktionen in Microsoft 365, GitHub und Teams kann Microsoft direkt auf eine bestehende Nutzerbasis von mehreren hundert Millionen Menschen zugreifen. Dies eröffnet zusätzliche Wertschöpfungspotenziale innerhalb eines bereits etablierten Software-Ökosystems.

In einem sich wandelnden Umfeld wie diesem stehen Unternehmen, denen diese beiden entscheidenden Pfeiler fehlen – nämlich eigene, kosteneffiziente Recheninfrastruktur sowie tief verankerte, breit angelegte Distributionskanäle – zwar möglicherweise mit exzellenten KI-Modellen da, werden langfristig aber grosse Herausforderungen haben, ihre Lösungen in breiter Masse zu skalieren und nachhaltige Margen zu erzielen. In dieser Hinsicht sind Microsoft und Alphabet gut aufgestellt, um die nächste Ära KI-getriebener Innovation und Wertschöpfung anzuführen.

1Dabei handelt es sich um ein mögliches Modell – es wird nicht immer eine separate oder einzelne Firma je Schicht geben. So deckt beispielsweise Microsoft sowohl die Compute als auch die Application Layer ab.

2Multimodale LLMs können Informationen aus verschiedenen Modalitäten wie Text, Bildern, Audio und Video verarbeiten und verstehen – und auch Ausgaben in unterschiedlichen Formaten generieren.

3Eine Ergänzung der Vereinbarung Anfang dieses Jahres räumt Microsoft ein „Vorkaufsrecht“ auf jegliche neue Cloud-Computing-Kapazität ein, sollte OpenAI die Dienste eines konkurrierenden Cloud-Anbieters in Anspruch nehmen wollen.

4https://about.google/company-info/philosophy/

5Derzeit setzt Microsoft für seine Copilot-Dienste gegenüber Kunden die neuesten Modelle von OpenAI ein.

Es handelt sich hierbei um eine Marketing-Kommunikation / Finanzwerbung, die ausschließlich Informationszwecken dient. Jegliche Prognosen, Meinungen, Ziele, Strategien, Ausblicke und/oder Schätzungen und Erwartungen oder andere nicht-historische Kommentare, die in diesem Dokument enthalten sind oder darin zum Ausdruck kommen, basieren ausschließlich auf aktuellen Prognosen, Meinungen und/oder Schätzungen und Erwartungen und gelten als „zukunftsorientierte Aussagen“. Zukunftsgerichtete Aussagen unterliegen Risiken und Unsicherheiten, die dazu führen können, dass die tatsächlichen zukünftigen Ergebnisse von den Erwartungen abweichen.

Dies ist keine Empfehlung, kein Angebot und keine Aufforderung zum Kauf oder Verkauf von Finanzprodukten. Der Inhalt ist nicht als Angebot gedacht und sollte nicht zu Buchhaltungs-, Rechts- oder Steuerberatungszwecken herangezogen werden. Der Inhalt, einschließlich externer Datenquellen, gilt als zuverlässig, es werden jedoch keine Zusicherungen oder Gewährleistungen gegeben. Es wird keine Verantwortung oder Haftung für die Änderung, Berichtigung oder Aktualisierung der hierin enthaltenen Informationen übernommen.

Bitte beachten Sie, dass die Wertentwicklung in der Vergangenheit nicht als Indikator für die zukünftige Wertentwicklung angesehen werden sollte. Der Wert der auf dieser Website enthaltenen Anlagen und/oder Finanzinstrumente und die daraus erzielten Erträge können schwanken und die Anleger erhalten möglicherweise nicht den ursprünglich investierten Betrag zurück. Auch Währungsbewegungen können dazu führen, dass der Wert von Anlagen steigt oder fällt.

Diese Inhalte sind nicht für den Gebrauch durch US- Personen bestimmt. Sie können von Zweigstellen oder Filialen von Banken oder Versicherungsgesellschaften genutzt werden, die nach US-Bundesrecht oder US-Staatsrecht organisiert und/oder reguliert sind und im Namen von Nicht-US-Personen handeln oder Unterlagen an diese verteilen. Diese Unterlagen dürfen nicht an die Kunden dieser Zweigstellen oder Filialen oder an die breite Öffentlichkeit verteilt werden.

Erhalten Sie unsere neuesten Erkenntnisse und Veranstaltungshinweise direkt in Ihrem Posteingang

„*“ zeigt erforderliche Felder an