Más de dos años después del lanzamiento de ChatGPT de OpenAI, que desencadenó una ola de interés en la inteligencia artificial (IA) generativa, las implicaciones a largo plazo de esta tecnología siguen siendo altamente inciertas. El ritmo de innovación es vertiginoso, los marcos regulatorios aún están en desarrollo y el valor económico final de muchos casos de uso de la IA está por demostrar. Sin embargo, en medio de esta incertidumbre, las estrategias de los gigantes tecnológicos empiezan a perfilarse: algunos están invirtiendo intensamente en desarrollar sus propios modelos, como Alphabet y Meta, mientras que otros adoptan un enfoque más agnóstico en cuanto al modelo, como Microsoft y Amazon.

En un panorama en el que las mejoras en el rendimiento de los grandes modelos de lenguaje (LLM) pueden erosionarse rápidamente, la capacidad de escalar la distribución a través de plataformas empresariales y de consumo profundamente consolidadas probablemente resulte más decisiva que la diferenciación técnica por sí sola. En este boletín, analizamos cómo dos participadas de Seilern, Microsoft y Alphabet, están afrontando este reto. Aunque sus estrategias difieren en la ejecución, ambas han reconocido la necesidad de realizar grandes inversiones iniciales, imprescindibles para desbloquear nuevas fuentes de ingresos y reforzar sus posiciones competitivas, sustentadas en su papel como hyperscalers de la nube y en la potente ventaja en distribución que ello conlleva.

Enfoque agnóstico de Microsoft respecto al modelo

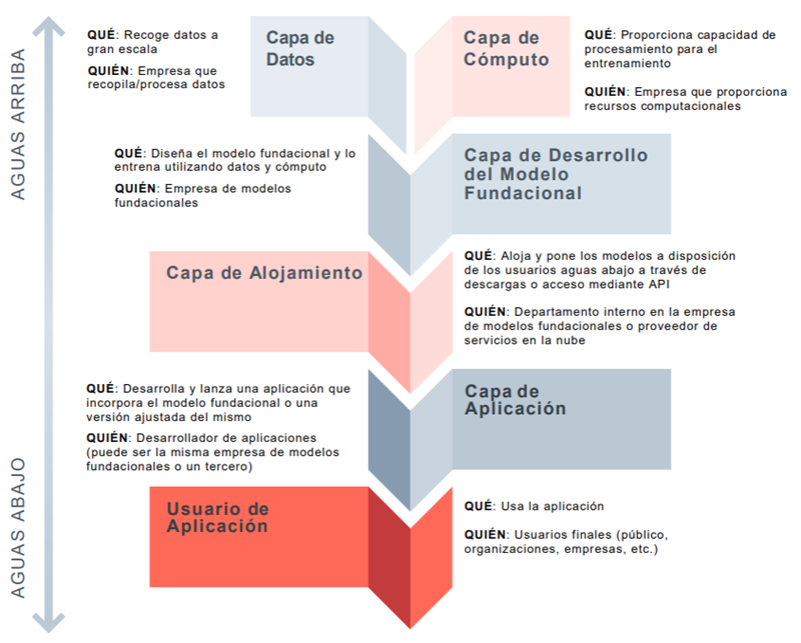

La estrategia de Microsoft en inteligencia artificial generativa se centra en la distribución a través de un enfoque agnóstico respecto al modelo LLM. A diferencia de sus competidores que dan prioridad al desarrollo de modelos de vanguardia, Microsoft ha puesto estratégicamente el acento en el despliegue aguas abajo, partiendo de la premisa de que los LLM están en camino de convertirse en productos comoditizados. Aunque una gran parte de los ingresos actuales de Microsoft relacionados con la IA —que se prevé que alcancen los 13 mil millones de USD en términos anualizados— provienen de las cargas de trabajo de entrenamiento de modelos de OpenAI (la “capa de computación” en la figura inferior) alojadas en Azure, Microsoft está reorientando cada vez más sus inversiones en infraestructura y su generación de ingresos hacia las cargas de trabajo de inferencia (la “capa de aplicación”), que ofrecen oportunidades de monetización más inmediatas y, según la empresa, un mayor potencial a largo plazo.

Figura 1: Ejemplo de cadena de suministro de un gran modelo de lenguaje (LLM)1

Fuente: The Ada Lovelace Institute

Un ejemplo de ello es Azure AI Foundry, que ofrece a los clientes empresariales acceso a más de 10.000 modelos, incluyendo acceso exclusivo a los modelos de OpenAI junto con muchos otros como los modelos de código abierto de Meta y DeepSeek y, más recientemente, las propuestas de xAI. El objetivo de Foundry es proporcionar una plataforma unificada para que los desarrolladores utilicen el modelo que mejor se adapte a sus necesidades, permitiéndoles probar y desplegar modelos de IA directamente. La meta última es impulsar la demanda de computación para inferencia en la red de Azure facilitando y haciendo atractiva la utilización de una amplia gama de modelos de IA en su plataforma. Este enfoque agnóstico respecto al modelo garantiza que Microsoft siga siendo un actor central independientemente de qué modelos específicos de IA acaben ganando protagonismo.

La evolución de la asociación de Microsoft con OpenAI, iniciada en 2019, ofrece valiosas pistas sobre su dirección estratégica. Cabe destacar que Microsoft se ha mantenido al margen del ambicioso «Proyecto Stargate» de OpenAI, que prevé una inversión de 500 mil millones de USD en infraestructura de computación durante los próximos cuatro años. Aunque Microsoft conserva los derechos exclusivos de distribución de los modelos de OpenAI, su decisión de no incrementar significativamente los compromisos de infraestructura para fines de entrenamiento está en consonancia con su estrategia agnóstica respecto al modelo. El objetivo de Microsoft es que Azure sea la plataforma preferida no solo para los modelos de OpenAI, sino para cualquier modelo que sus clientes elijan para sus necesidades de inferencia.

En lugar de aumentar agresivamente el gasto de capital en previsión de futuros avances, Microsoft está calibrando sus inversiones incrementales en el lado de la oferta (como los clústeres de GPU, la expansión de centros de datos y el desarrollo de modelos propios) en función de la demanda observable de los clientes y del valor real obtenido de las cargas de trabajo de inferencia. En términos prácticos, Microsoft supervisa de cerca los patrones de uso, las tasas de adopción por parte de empresas y la contribución a los ingresos de las herramientas de IA desplegadas, y utiliza estas métricas para orientar nuevas inversiones en infraestructura. Este enfoque basado en la demanda garantiza que el capital se destine a donde el uso probablemente sea más persistente y donde las vías de beneficios futuros sean más claras y previsibles.

La ventaja técnica y de costes de Alphabet

El enfoque de Alphabet respecto a la IA generativa se basa en su filosofía de innovación continua, aprovechando sus capacidades en investigación a través de Google DeepMind, en infraestructura mediante su servicio Google Cloud y en distribución gracias a sus productos y servicios utilizados por miles de millones de clientes en todo el mundo. Aunque la empresa ofrece modelos de IA de terceros, también está invirtiendo estratégicamente en la construcción de su propio ecosistema de IA generativa con su familia de LLM multimodal, Gemini.2 Si bien los tres grandes hyperscalers (Amazon, Microsoft y Google) ofrecen servicios en la nube integrales, a menudo se cita a Google como el que cuenta con la infraestructura de nube más verticalmente integrada, desde cableado submarino hasta un uso extensivo de silicio personalizado de desarrollo propio, lo que le proporciona varias ventajas estratégicas.

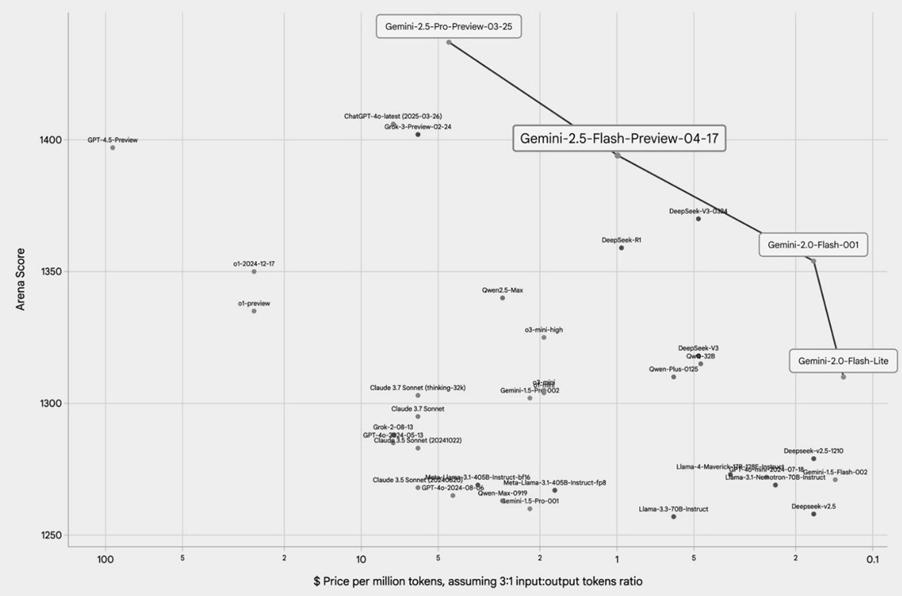

Un ejemplo destacado de ello son sus unidades de procesamiento Tensoriales (TPU, por sus siglas en inglés), chips diseñados específicamente para tareas de computación en IA. Implantadas por primera vez en sus centros de datos en 2015, estas TPU ahora impulsan todo el entrenamiento y la inferencia de sus modelos más avanzados, los Gemini. Gracias a años de iteración continua, las TPU han permitido a Google ofrecer algunos de los mejores modelos de IA de su clase, y además con una eficiencia de costes extraordinaria. Como ilustra el gráfico a continuación, los modelos de Google operan en la “frontera de Pareto” entre rendimiento (eje vertical) y coste (eje horizontal), lo que los convierte en una propuesta muy atractiva para los clientes. En otras palabras, cualquier alternativa sería subóptima para el usuario, ya que cualquier mejora en un aspecto (como el precio) implicaría inevitablemente una cesión en otro (como el rendimiento).

Figura 2: Rendimiento de grandes modelos de lenguaje (LLM) frente al coste por computación

Fuente: Google for Developers Blog (17 de abril de 2025)

Estos chips proporcionan a Google una ventaja estructural en costes que se extiende a lo largo de toda su operación en IA. Mientras que competidores como OpenAI (dependiente de Microsoft Azure) y Anthropic (dependiente de Amazon Web Services) deben adquirir costosa infraestructura en la nube de terceros para cubrir sus necesidades de computación —soportando a menudo lo que algunos denominan el «impuesto Nvidia» sobre las GPU de gama alta—, el hardware propietario de Google le permite evitar una parte significativa de estos costes externos.

El lanzamiento en febrero por parte de DeepSeek de sus modelos de IA de código abierto altamente competitivos puso de manifiesto las asombrosas ineficiencias en costes de muchos desarrolladores de grandes modelos de lenguaje (LLM) y supuso un contundente toque de atención para el sector. Sin embargo, en el caso de Google, tras años de inversión en entrenamientos optimizados en costes y una década de iteración y mejora continua de sus TPU, el impacto fue notablemente limitado. En una entrevista reciente, Sundar Pichai, CEO de Alphabet, señaló que cuando Google comparó sus modelos con los de DeepSeek, descubrió que sus propios modelos Gemini eran igual de eficientes y, en algunos casos, incluso superiores. Esto demuestra la importante ventaja que Google obtiene gracias a su enfoque de hardware integrado.

La distribución sigue siendo clave

Aunque el impulso actual en torno a la IA generativa parece imparable, siempre existe el riesgo de que la demanda se enfríe más rápidamente de lo previsto. Por improbable que hoy parezca este escenario, Alphabet y Microsoft están especialmente protegidas frente a una posible desaceleración precisamente por su condición de hyperscalers de la nube y por sus capacidades de distribución sin parangón. Incluso si el entusiasmo inmediato por determinadas aplicaciones de IA disminuyera, la demanda subyacente de computación en la nube, almacenamiento de datos y software empresarial esencial se mantendría. A medida que el panorama de la IA generativa sigue evolucionando, los verdaderos ganadores no se decidirán únicamente por quién construya los modelos más avanzados, sino por quién sea capaz de distribuirlos de forma más eficaz a gran escala.

Consideremos el caso de OpenAI. Aunque se la percibe ampliamente como una empresa líder en innovación de modelos de IA, su viabilidad operativa y comercial está intrínsecamente ligada a Microsoft. En el marco de su alianza, OpenAI utiliza Microsoft Azure para cubrir sus necesidades de computación,3 y todas sus cargas de trabajo de API están alojadas exclusivamente en Azure. Este acuerdo no solo otorga a Microsoft acceso exclusivo a la tecnología más avanzada de OpenAI, sino que también consolida la posición de Azure como capa fundamental en la creciente pila de tecnologías de IA. Lo más relevante es que esto pone de relieve una importante limitación estratégica para OpenAI, dada su dependencia de la infraestructura y las capacidades de distribución de Microsoft, lo que restringe su independencia y amplifica su riesgo de ejecución. Al no contar con su propia nube de categoría hyperscale, OpenAI debe depender de Microsoft no solo para obtener la potencia de cálculo necesaria para entrenamiento e inferencia, sino también, cada vez más, para llegar a los clientes en puntos de contacto empresariales clave. Esta profunda dependencia hace que el camino de OpenAI hacia una rentabilidad sostenida sea considerablemente más incierto.

Por el contrario, la fortaleza de hyperscalers como Alphabet y Microsoft radica en su control sin precedentes sobre el recurso fundamental para la IA —la infraestructura de computación— y en su capacidad para operarla con una eficiencia extrema a gran escala, junto con sus vastas capacidades de distribución. Tal y como analizó anteriormente mi compañera Nina, el núcleo de la estrategia de Google se resume en su antiguo lema: «concéntrate en el usuario y lo demás vendrá solo».4 Al integrar sin fricciones capacidades avanzadas de IA en productos y servicios existentes de los que ya dependen miles de millones de usuarios —como Android, Gmail, YouTube, Workspace y Search—, Google logra generar un mayor nivel de interacción y ofrecer experiencias más personalizadas. Este uso de alta frecuencia, combinado con una integración estrecha de productos y una recopilación continua de datos, proporciona una base sólida para la fidelización del usuario y, en última instancia, la monetización.

Del mismo modo, Microsoft está integrando estratégicamente su asistente digital impulsado por IA, Copilot,5 directamente en sus populares soluciones de software. Este enfoque añade capacidades de IA exactamente allí donde ya se realiza una parte significativa del trabajo empresarial, eliminando la necesidad de crear aplicaciones completamente nuevas para dar cabida al uso de la IA. Al incorporar funciones de IA en Microsoft 365, GitHub y Teams, Microsoft accede directamente a una base instalada de cientos de millones de usuarios. A su vez, esto posiciona a la empresa para captar aún más valor al potenciar un ecosistema de software ya consolidado.

En este panorama en constante evolución, las empresas que carecen de estos dos pilares fundamentales —una infraestructura de computación propia y eficiente en costes, y canales de distribución amplios y profundamente integrados— pueden desarrollar modelos de IA brillantes hoy, pero afrontarán obstáculos significativos para llegar a los usuarios a gran escala y lograr márgenes sostenibles a largo plazo. En este sentido, tanto Microsoft como Alphabet están bien posicionadas para liderar la próxima era de innovación y creación de valor impulsadas por la IA.

1Nota: este es solo un modelo posible (no siempre habrá una empresa distinta o única en cada capa; por ejemplo, Microsoft proporciona tanto la capa de computación como la de aplicación).

2Los LLM multimodales pueden procesar y comprender información procedente de múltiples modalidades como texto, imágenes, audio y vídeo, y también generar resultados en múltiples formatos.

3Una enmienda al acuerdo a principios de este año otorga a Microsoft el «derecho de tanteo» sobre cualquier nueva capacidad de computación en la nube en caso de que OpenAI busque recurrir a un proveedor de nube rival.

4https://about.google/company-info/philosophy/

5Actualmente, Microsoft utiliza los modelos más recientes de OpenAI para sus servicios Copilot dirigidos a los clientes.

La presente es una comunicación de marketing / promoción financiera destinada únicamente a fines informativos y no constituye un asesoramiento de inversión. Cualquier previsión, opinión, meta, estrategia, previsión, estimación o expectativa, u otro comentario no histórico contenido o expresado en el presente documento está basado exclusivamente en previsiones, opiniones o estimaciones y expectativas actuales, y se considera, por tanto, una «proyección futura». Las proyecciones futuras están sujetas a riesgos e incertidumbres que podrían hacer que los auténticos resultados futuros difieran de nuestras expectativas.

Esta no es una recomendación, oferta o solicitud para comprar o vender ningún producto financiero. El contenido no está destinado a proporcionar asesoramiento contable, jurídico o fiscal y no debe ser utilizado para tales fines. Se cree que el contenido, incluidas las fuentes de datos externas, es fiable, pero no se ofrecen garantías al respecto. No se aceptará responsabilidad alguna en relación con la modificación, la corrección ni la actualización de la información aquí contenidas.

Tenga en cuenta que la rentabilidad histórica no debe considerarse una indicación de los resultados futuros. El valor de cualquier inversión y/o instrumento financiero incluido en este sitio web, así como las rentas obtenidas con ellos, podrían fluctuar y el inversor podría no recuperar el importe invertido originalmente. Los movimientos de divisas también pueden hacer que el valor de las inversiones suba o baje.

Este contenido no está destinado a ser utilizado por Personas Estadounidenses. Puede ser utilizado por sucursales o agencias de bancos o compañías de seguros constituidas o reguladas con arreglo a la legislación federal o estatal de Estados Unidos, que actúen en nombre o distribuyan a Personas No Estadounidenses. Este material no debe distribuirse a clientes de dichas sucursales o agencias ni al público en general.

Reciba información sobre nuestras novedades y eventos en su buzón de correo

"*" señala los campos obligatorios